Cum te ajută AI-ul Google să cauți ceea ce vezi, de la imagini la video

Share

Share the post "Cum te ajută AI-ul Google să cauți ceea ce vezi, de la imagini la video"

Produsele Google își propun să fie cât mai mult de ajutor oamenilor care le folosesc. Încă de la începuturile Căutării Google, compania a folosit inteligența artificială pentru a înțelege limbajul și a face rezultatele căutării mai utile. De-a lungul timpului, Google și-a mărit eforturile și investițiile în AI, iar astfel a reușit înțelegerea informației în feluritele ei forme – de la înțelegerea limbajului până la imagini, video și chiar înțelegerea vieții reale. După ce a anunțat următorul pas în evoluția sa în domeniul AI-ului, Google prezintă câteva moduri în care aplică progresele în acest domeniu pentru a face explorarea informației mai naturală și intuitivă.

Caută după ceea ce vezi

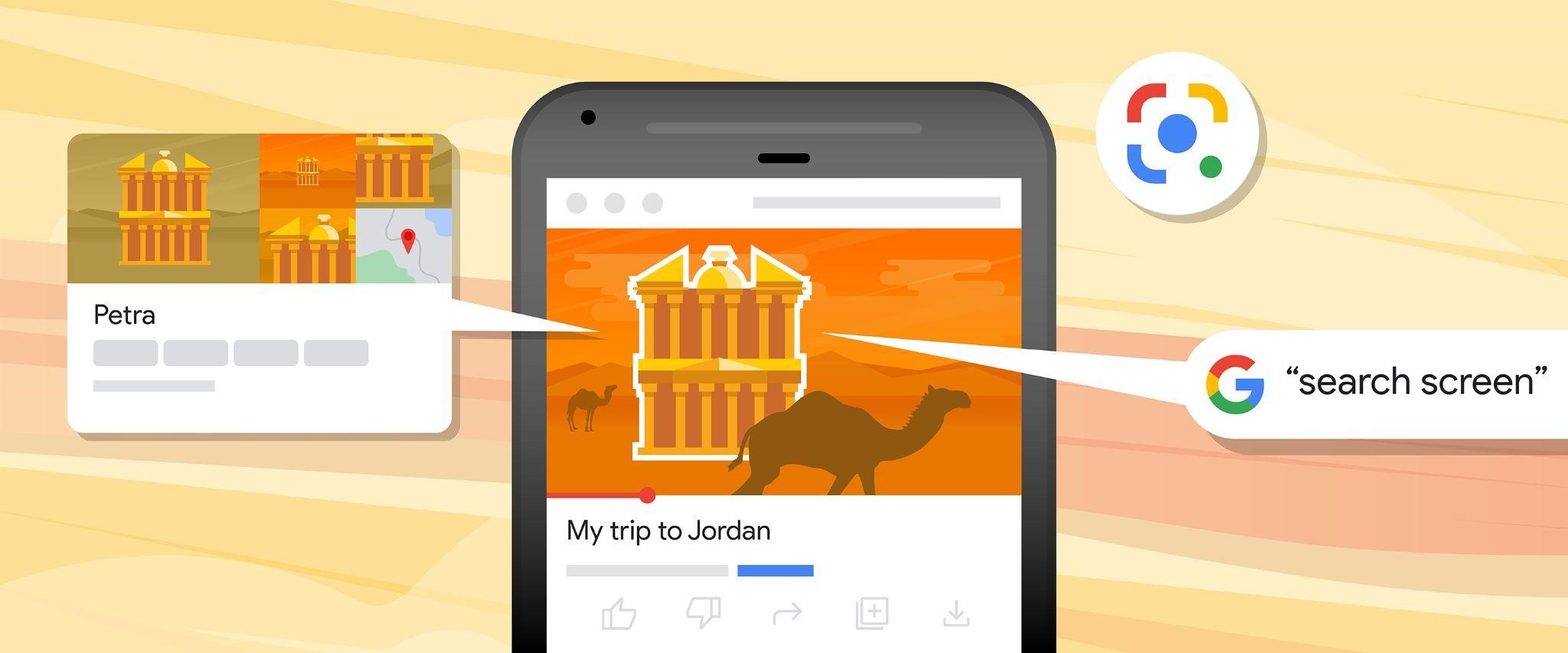

În fiecare lună, funcția Lens de la Google este utilizată de peste 10 miliarde de ori de oameni pentru a căuta ce văd folosind camera telefonului sau imagini. Lens poate fi utilizată direct din bara de Căutare, iar acum Google anunță o actualizare care va ajuta căutarea de pe ecranul telefonului.

În următoarele luni, Lens va putea fi utilizat pentru a căuta pe ecranul telefonului Android. Cu această nouă tehnologie, utilizatorii vor putea căuta ce văd în pozele sau video-urile din site-urile web pe care intră sau aplicațiile pe care le folosesc, precum cele de mesagerie sau video, fără a părăsi aplicația sau browserul.

De exemplu, dacă te uiți la un video filmat în Paris și vrei să afli ce este reperul pe care îl vezi în fundal, apeși lung pe butonul Home sau pe cel de Power al telefonului Android, care activează Google Assistant, iar apoi selectezi „search screen” (caută pe ecran). Lens identifică reperul (o clădire, de exemplu), iar apoi poți să dai click pentru a afla mai multe informații despre el.

Sau dacă într-un video apare un obiect care te interesează – un scaun, de exemplu, poți afla de unde poți să-l cumperi sau căuta scaune care arată ca el. După ce activezi Google Assistant și apoi selectezi „search screen”, Lens va analiza și identifica elementele din imaginea care apare pe ecran, utilizatorul va selecta pe cel de care este interesat – în cazul acesta, scaunul care apare în imagine – și va avea acces la diferite opțiuni despre ce fel de informații dorește să primească legate de elementul selectat.

Cum să combini diferitele moduri de a căuta

În urmă cu aproape un an, Google a prezentat Multisearch, un nou mod de a căuta, folosind imagini și text în același timp. Începând de săptămâna aceasta, Multisearch este disponibil la nivel global pe mobil, în toate limbile și țările în care Lens este disponibil, inclusiv în România.

Față de prezentarea inițială, Multisearch a progresat, fiindu-i adăugată abilitatea de a căuta local. Astfel, utilizatorul poate pleca de la o poză și căuta „în apropiere” pentru a găsi în zona geografică în care se află elementul pe care-l dorește din poză. În prezent, această opțiune este valabilă în Statele Unite, dar în următoarele luni va fi extinsă global.

De asemenea, în următoarele luni Multisearch va putea fi folosit global pentru orice imagine care apare în rezultatele căutării pe mobil. De exemplu, cineva caută „idei de living modern” și vede în căutări o masă de cafea rotundă care i se pare interesantă, dar ar dori-o în altă formă. Cu Multisearch va putea adăuga pozei textul „dreptunghiular” și căuta astfel masa în stilul respectiv, dar în altă formă. Același lucru îl poți face în cazul unei bluze găsite pe internet care îți place, dar ai dori-o în altă culoarea: folosești Multisearch combinând poza bluzei și adăugând text cu culoarea dorită.

Progresele de astăzi ale Lens permit utilizatorilor să caute orice văd. În viitor, cu ajutorul inteligenței artificiale, posibilitățile de evoluție a căutării sunt nelimitate.